网站robots.txt怎么写,robots.txt写法大全解析。robots文件的作用是告诉搜索引擎蜘蛛,网站的哪些文件夹可以抓取,哪些文件夹不能抓取,从而确保我们网站的隐私内容不会被收录。

工具/原料

电脑/笔记本

写在前面:

1、robots.txt文件是什么?robots.txt是存放在网站根目录下的一个TXT文本文档,它是网站和蜘蛛之间的一个协议(蜘蛛协议)。

2、robots.txt文件哟什么用?robots.txt的作用是告诉搜索引擎爬虫,网站的哪些文件夹可以抓取,哪些文件夹不能抓取,从而确保我们网站的隐私内容不会被索引。

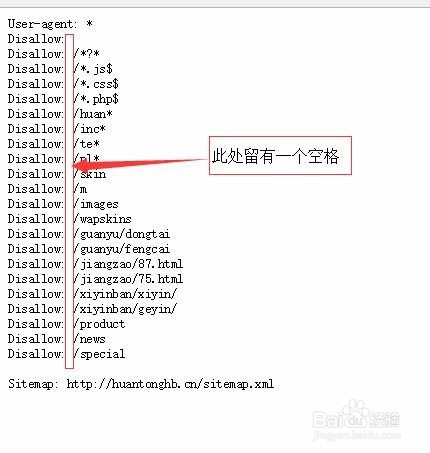

3、书写robot衡痕贤伎s文件注意事项:1.robots文件的后缀必须是.txt;2.robots文件应该存放在网站的根目录,而且所有字母都必须小佯鲅烫侬写;3.在写robots文件的时候,User-agent、Disallow、Allow、Sitemap这些词开头第一个字母必须大写,后面的字母则要小写;4.特别注意,在:后面必须有一个英文状态下的空格。

robots.txt写法大全解析:

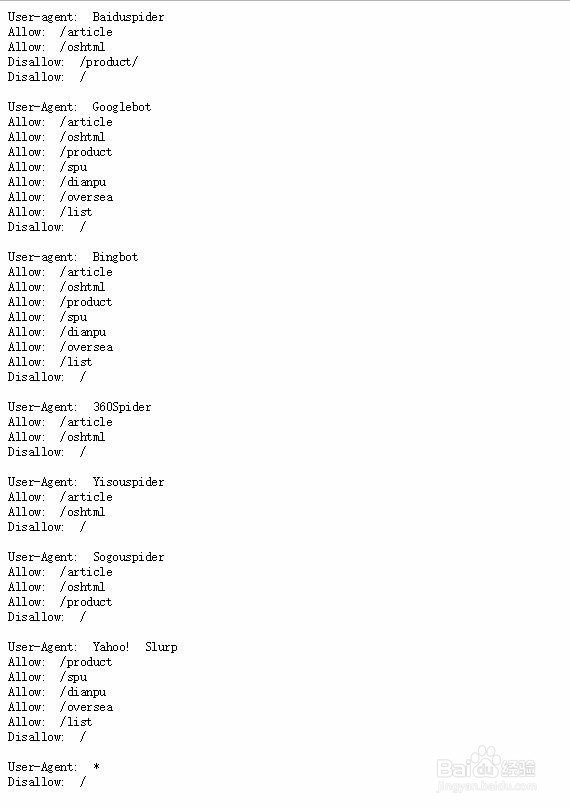

1、自定义搜索引擎:用User-agent:来定义搜索引擎,其中*表示所有百度蜘蛛名字:Baiduspi颊俄岿髭der,谷歌蜘蛛名字:GooglebotUser-agent:* 表示定义所有蜘蛛User-agent: Baiduspider表示自定义百度蜘蛛User-agent: Googlebot表示自定义谷歌蜘蛛大家可以参考百度或者某宝的robots.txt,他么就有对个别搜索引擎爬虫禁止抓取。

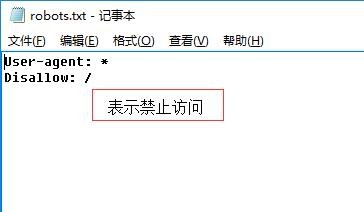

2、禁止访问和允许访问:禁止所有搜索引擎访问:User-agent: *Disallow: /=====华丽丽的分割线=====允许所有搜索引擎访问:User-agent: *Allow: /注意:在:后面/前面有一个英文状态下的空格,空格必须有,必须是英文状态下的

3、禁止毛殴陀灾搜索引擎访爬虫问网站中的某些目录:假设【abc】是我网站根目录的一个文件夹,写法分别如下:User-agent: *Disallow: /abc禁止搜索引擎访问abc文件夹及abc文围泠惶底件夹下面的所有文件=====华丽丽的分割线=====User-agent: *Disallow: /abc/禁止搜索引擎访问abc文件夹下面的所有文件,但是abc文件夹是允许被访问的

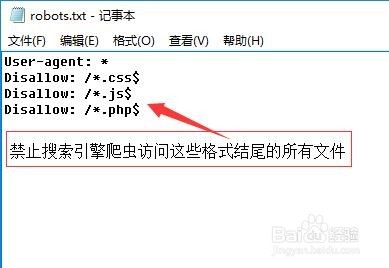

4、禁止搜索引擎爬虫访问某一类文件:例如我们要禁止搜索引擎蜘蛛访问css、js、php等文件,可以这样写:User-agent: *Disallow: /*.css$Disallow: /*.js$Disallow: /*.php$注意:*表示所有,$表示结尾

5、禁止访问网站中的动态页面:User-agent: *Disallow: /*?*注意:?表示动态路径,*表示所有。

6、只允许搜索引擎爬虫访问网站首页:User-agent: *Disallow: /*

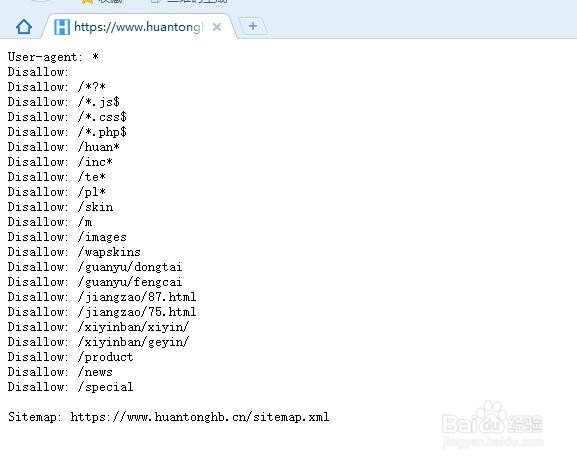

7、最后是我一个网站的robots.txt的文件,我是这样写的,大家可以作参考: