1、安装前的准备所需软件:

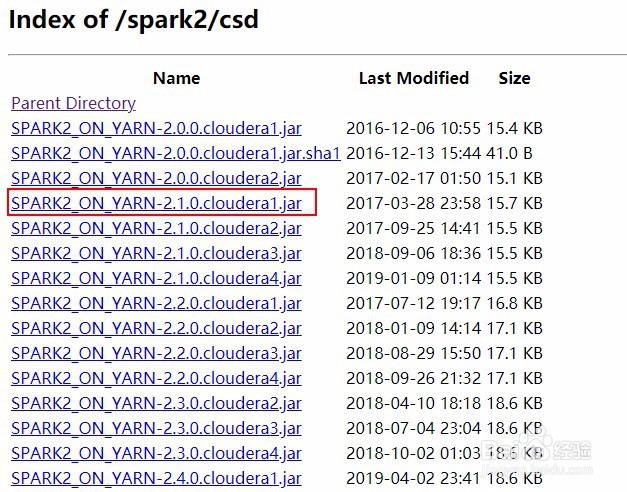

2、Parcels 包地址

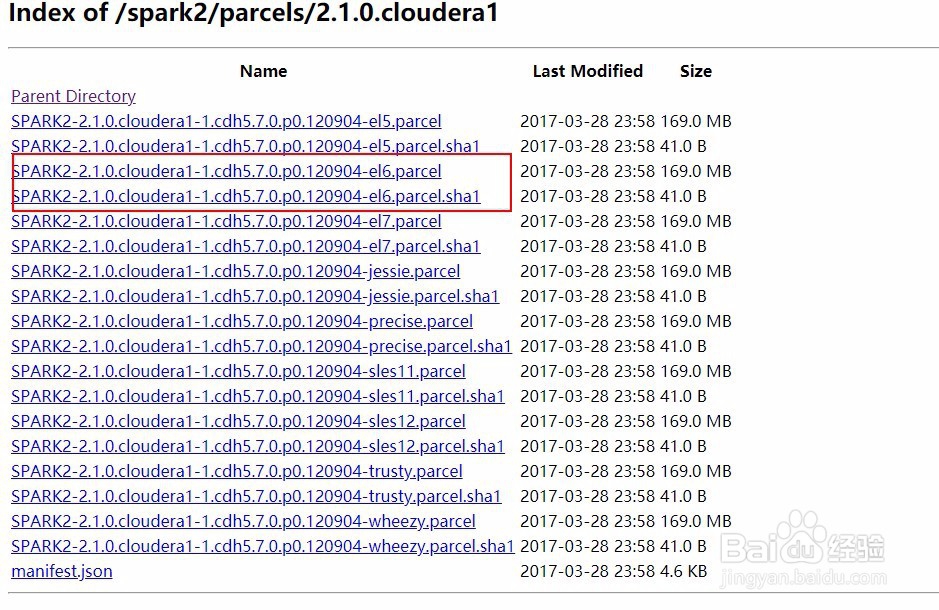

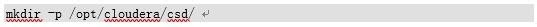

3、安装过程1)创建csd目录

4、2)上传文件SPARK2_ON_YARN-2.1.0.cloudera1.jar 到 /opt/cloudera/csd/下面

5、3)上传文件SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel和SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel.sha1 到/opt/cloudera/parcel-repo/

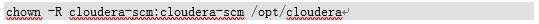

6、4)修改所属用户及用户组:

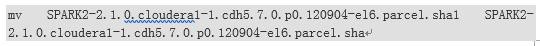

7、5)将SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel.sha1重命名为SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel.sha

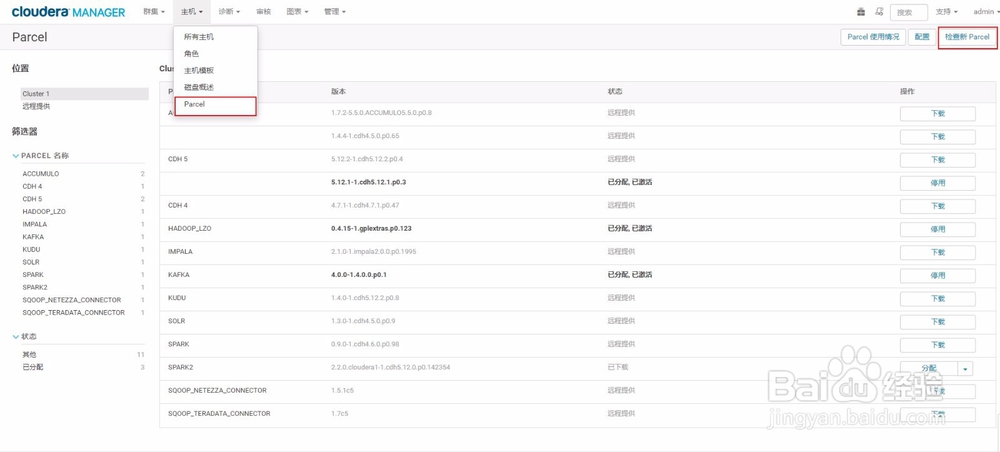

8、页面操作1)在cm首页点击Parcel,再点击检查新Parcel

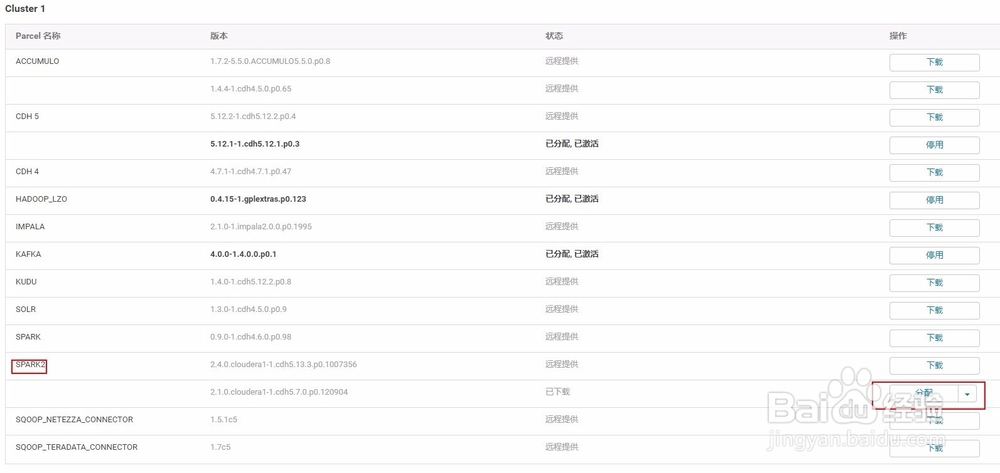

9、2)点击分配

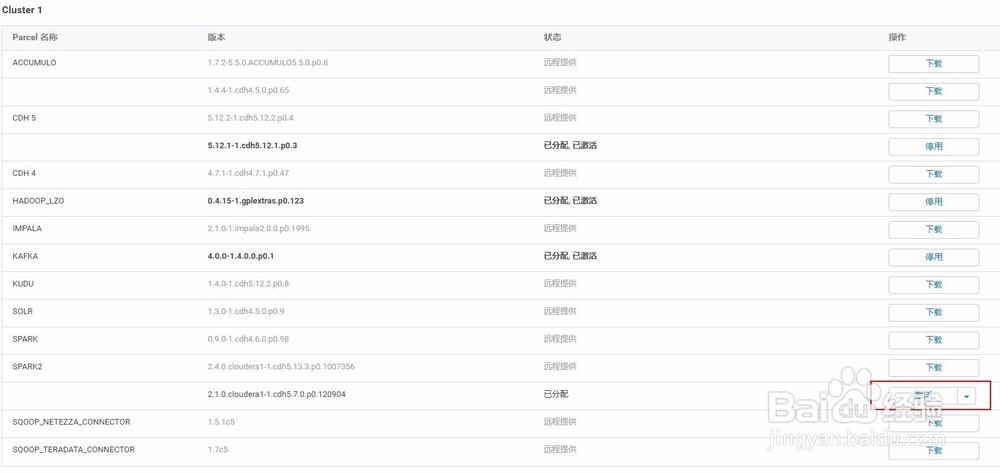

10、3)点击激活

11、4)回到首页点击添加服务

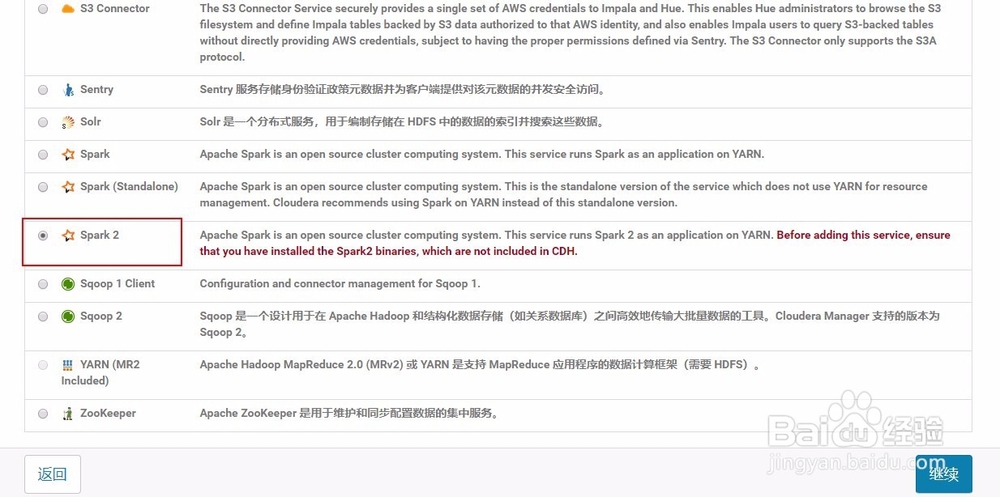

12、5)点击spark2继续

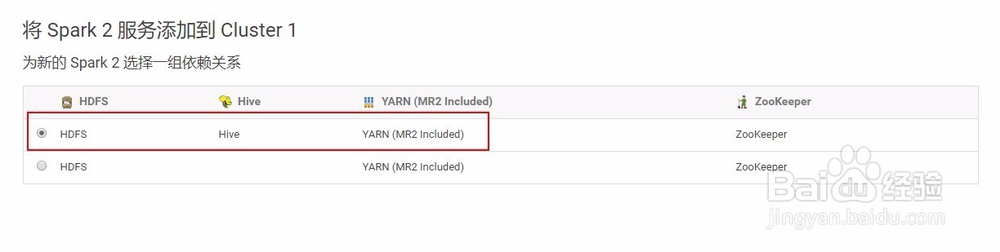

13、6)选择一组依赖关系

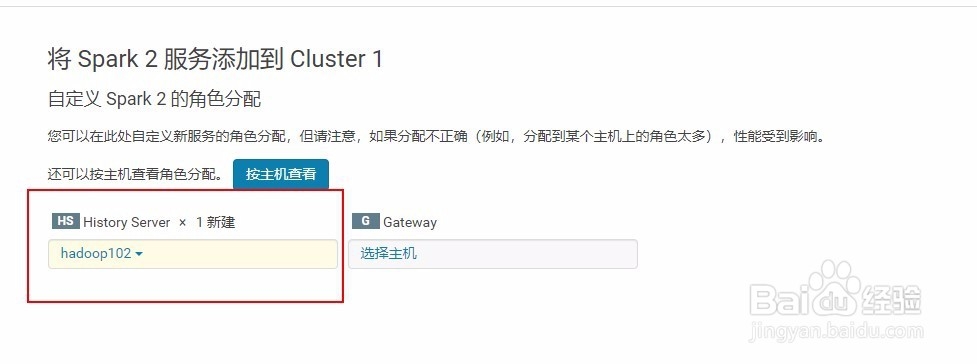

14、7)角色分配

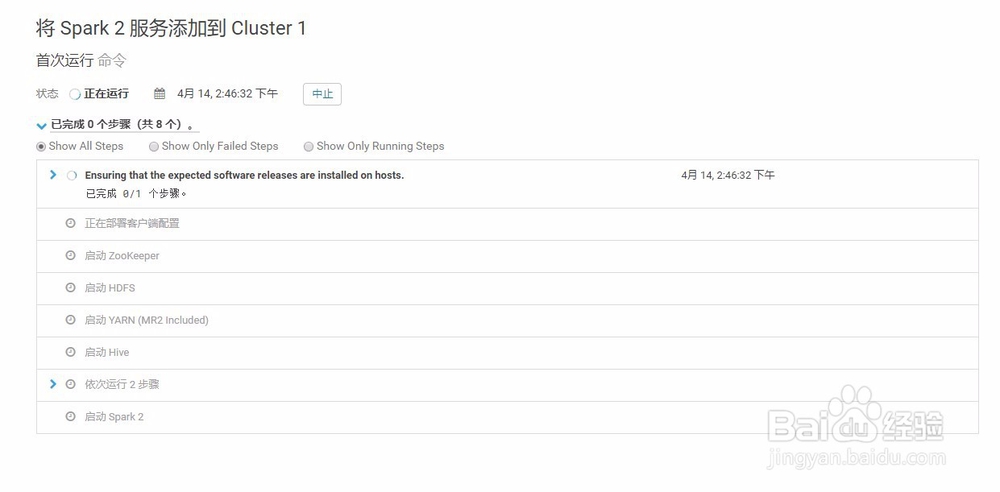

15、8 )部署并启动

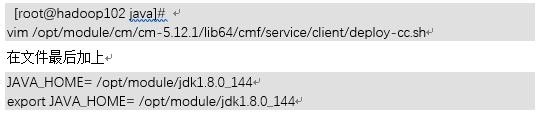

16、9 错误解决如果报错:客户端配置 (id=12) 已使用 1 退出,而预期值为 0因为cm安装spark不会去环境变量去找java,需要将java路径添加到cm配置文件解决方法:

17、10)命令行查看命令